Das Mantra „Daten sind das neue Öl“ mag abgedroschen klingen, trifft aber eine wesentliche Wahrheit. Ähnlich wie Öl durchlaufen die Daten der Entwicklung eine komplexe Wertschöpfungskette: von der Erfassung über die Aufbereitung und Analyse bis hin zur Speicherung und Nutzung.

Erhebung

Aufbereitung

Transport

Analyse

Speicherung

Nutzung

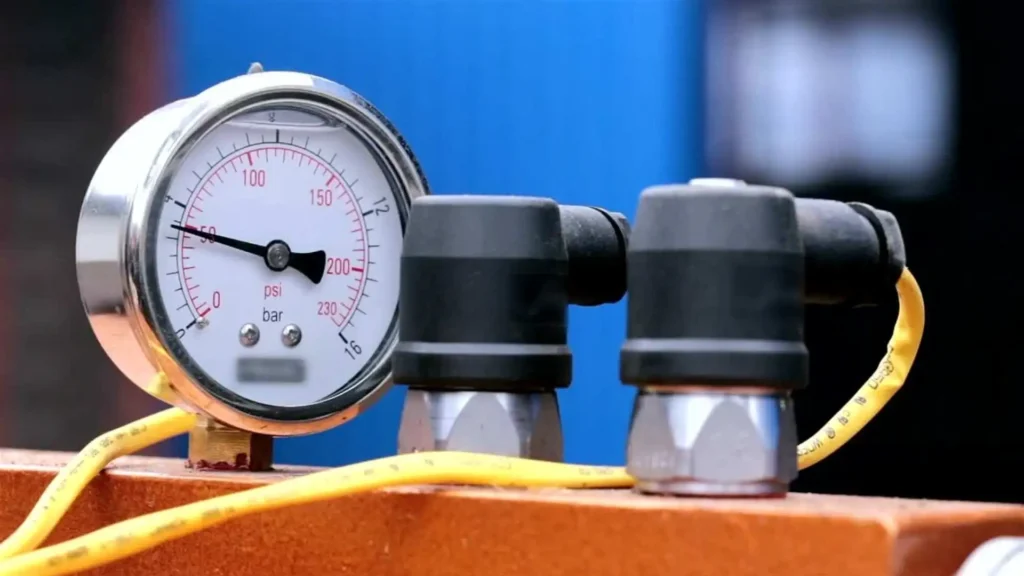

Datenqualität und -integrität gewährleisten: Die Qualität der Rohdaten (Genauigkeit, Konsistenz, Vollständigkeit, Datenrate und Aktualität) bestimmt die Obergrenze der Datenqualität in der gesamten Datenwertschöpfungskette.

Homogenisieren: Unterschiedliche Sensortypen und -technologien erfordern spezifische Implementierungen und Kalibrierungen.

Die Erhebung erfordert daher eine Homogenisierung der erfassten Größen, um sicherzustellen, dass alle Daten konsistent und vergleichbar sind. Die Verwendung unterschiedlicher Protokolle und Standards kann die Interoperabilität erheblich erschweren.

Wirtschaftlichkeit berücksichtigen: Sensoren und die dazugehörige Hardware können teuer sein. Digitale Erhebungen können ebenfalls kostspielig sein, da sie erhebliche Rechenressourcen erfordern, insbesondere wenn hohe Genauigkeit und Zuverlässigkeit erforderlich sind. Die Wirtschaftlichkeit der Datenerhebung muss daher sorgfältig abgewogen werden, um das Verhältnis zwischen Kosten und Nutzen zu optimieren.

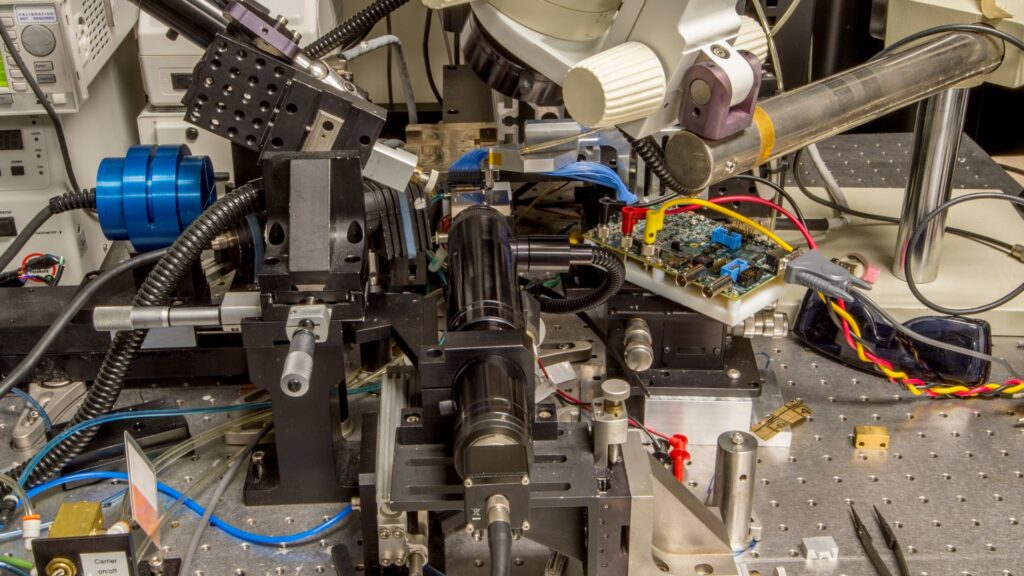

Kontextualisieren: Umwandlung der Rohdaten in nutzbare Messwerte durch Hinzufügen von Kontextinformationen wie Zeit, Einheit und Name. Durch diese Kontextualisierung wird die Nutzbarkeit der Daten hergestellt.

Vorverarbeiten: Lokale Aufbereitung der Daten für die Nutzung durch Filterung, Transformation, Verschlüsselung und Komprimierung. Die Auswahl und Konfiguration der zu messenden Signale und der zu setzenden Parameter ist ebenso aufwendig wie die Anpassung der Datenaufbereitungsprozesse an sich ändernde Anforderungen und Umgebungen.

Kommissionieren: Sammeln und Zusammenführen von Daten und Handhabung von Ein- und Ausgabeschnittstellen. Prozessgrößen, Signale und Parameter sind oft schwer zugänglich. Unterschiedliche Schnittstellen und heterogene Systeme erfordern spezifische Methoden und Lösungen.

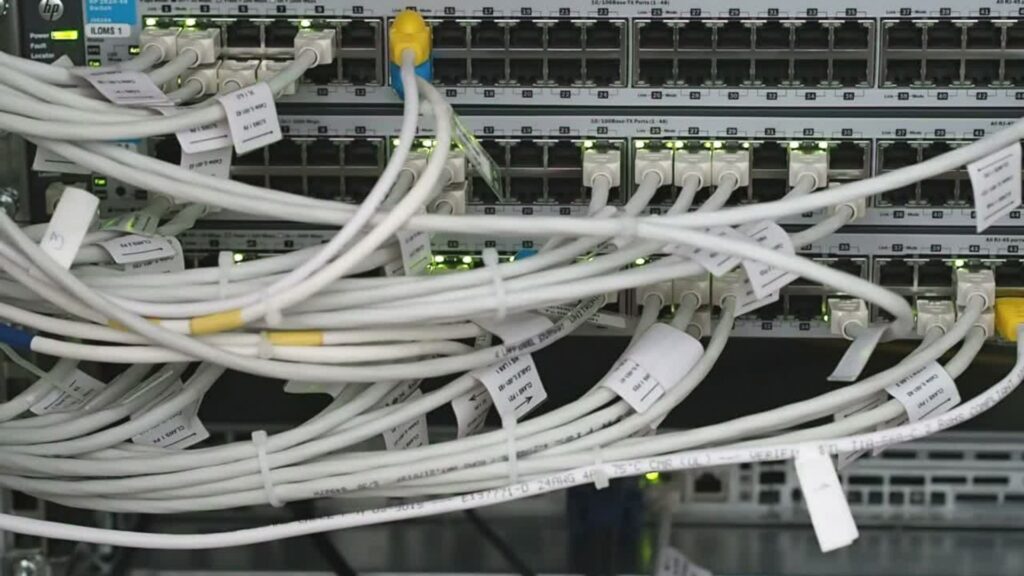

Übertragen: Die Daten müssen über geeignete Hardwareschnittstellen und Kommunikationselemente übertragen werden. Diese Hardware kann teuer sein und sollte daher nur installiert werden, wenn sie wirklich benötigt wird.

Die Vielfalt der Technologien kann zu einer gewissen Inflexibilität führen, wenn man sich einmal für eine Schnittstelle entschieden hat.

Berechnen: Daten werden über Protokolle und Kommunikations-Stacks übertragen. Diese müssen berechnet und verarbeitet werden, was die Kapazität der verwendeten Recheneinheit übersteigen kann, insbesondere in der Entwicklungsphase, wenn mehr Daten benötigt werden. Es muss sichergestellt werden, dass genügend Bandbreite zur Verfügung steht, um alle Daten in der erforderlichen Geschwindigkeit zu übertragen und Engpässe zu vermeiden, die die Datenübertragung verlangsamen oder unterbrechen könnten.

Sichern: Die Integrität und Sicherheit der Daten während des Transports muss gewährleistet sein. Dies beinhaltet den Schutz vor Datenverlust, Verfälschung und unberechtigtem Zugriff, was häufig durch Verschlüsselung und sichere Protokolle erreicht wird. Latenzzeiten und Paketverluste müssen vermieden werden, insbesondere bei Echtzeitanwendungen.

Visualisieren: Die Daten müssen so dargestellt werden, dass ihre Aussagekraft für die jeweilige Fragestellung optimiert werden kann. Dabei muss die Performance der Visualisierung sicherstellen, dass diese auch bei großen Datenmengen schnell und effizient erzeugt werden kann. Unterschiedliche Datenquellen und Kommunikationsprotokolle („Sprachen“) müssen gleichzeitig integriert und flexibel konfigurierbar gemeinsam dargestellt werden.

Analysieren: Die aufbereiteten Daten werden im Detail analysiert, um Abweichungen, Anomalien, Trends und Korrelationen zu erkennen und zu messen. Es ist wünschenswert, Analysekonfigurationen ohne großen Aufwand anzupassen, um flexibel auf sich ändernde Anforderungen reagieren zu können. Die Zuordnung zu Ereignissen wird durch deren Erkennung erleichtert. Wenn nur relevante Daten automatisch erfasst werden, reduziert sich der Analyseaufwand.

Optimieren: Auf Basis der Analyseergebnisse werden Optimierungsmaßnahmen durchgeführt, um die Leistungsfähigkeit und Effizienz der Systeme zu verbessern. Dies kann die Anpassung von Steuerungsparametern, die Einführung neuer Elemente oder die Optimierung bestehender Prozesse umfassen. Wenn Parameter in Echtzeit und bei laufendem System angepasst werden können und nicht für jede Änderung das Gerät neu programmiert werden muss, reduziert sich der Aufwand erheblich.

Organisieren: Die Daten müssen strukturiert und geordnet gespeichert werden, um ihre Zugänglichkeit und Nutzbarkeit zu gewährleisten. Dies umfasst die Organisation der Daten in Datenbanken, die Verwendung von Metadaten und die Sicherstellung, dass die Daten leicht auffindbar und abrufbar sind. Dabei ist es wichtig, die Datenintegrität zu gewährleisten und effiziente Indexierungs- sowie schnelle Abfragezeiten sicherzustellen.

Archivieren: Die Daten sollten so gespeichert werden, dass sie langfristig zugänglich und sicher aufbewahrt werden. Dies umfasst die Speicherung historischer Daten, die Bereitstellung von Zugriffskontrollen und die Sicherstellung der Datensicherheit. Die Sicherstellung der Datensicherheit und -vertraulichkeit, die Einhaltung von Compliance-Anforderungen sowie die effiziente Datenarchivierung und -wiederherstellung sind hierbei zentrale Herausforderungen.

Verwalten: Die Daten müssen so organisiert sein, dass sie für verschiedene Anwendungen und Analysen wiederverwendbar sind. Dies umfasst die Standardisierung von Datenformaten und die Bereitstellung von Schnittstellen für den Datenzugriff. Es ist wichtig, die Datenkonsistenz über verschiedene Anwendungen hinweg sicherzustellen und Datenänderungen sowie -aktualisierungen effizient zu handhaben.

Qualitätssicherung: Daten werden genutzt, um die Qualität der Prozesse und Produkte zu überwachen und sicherzustellen. Dies umfasst die Durchführung von Qualitätskontrollen, die Identifikation von Abweichungen und die Implementierung von Maßnahmen zur Fehlerbehebung. Durch die kontinuierliche Überwachung können Probleme frühzeitig erkannt und behoben werden, wodurch die Qualitätssicherung verbessert wird.

Steuern und Regeln im Betrieb: Die erfassten Daten werden verwendet, um den Betrieb der Systeme zu steuern und zu regeln. Dies beinhaltet die Anpassung von Steuerungsparametern, die Implementierung von Regelkreisen und die Echtzeit-Überwachung des Systemzustands. Durch den Einsatz von Daten können die Betriebsprozesse optimiert und die Effizienz gesteigert werden.

Überwachen und Verwalten im Betrieb: Die kontinuierliche Überwachung und Verwaltung der Betriebsdaten ist entscheidend, um den Zustand und die Leistung der Systeme zu bewerten. Dies umfasst die In-Life Datenverwaltung und Predictive Maintenance, wobei Daten genutzt werden, um den Zustand des Systems zu überwachen und vorausschauende Wartungsmaßnahmen zu planen. Eine effiziente Verwaltung großer Datenmengen und die Sicherstellung der Datenkontinuität und -genauigkeit sind dabei zentral.